Megan García, madre del adolescente Sewell Setzer, denunció a la empresa Character.AI por el suicidio de su hijo, quien se había enamorado de una personaje ficticio. El caso que recorrió el mundo bajo la lupa de una especialista.

De manera reciente se conoció la noticia que Megan García, madre del adolescente Sewell Setzer, denunció a la empresa Character.AI por el suicidio de su hijo en febrero. El menor de catorce años, residente en Orlando, Estados Unidos y diagnosticado con síndrome de Asperger leve de niño, se había enamorado de Daenerys Targaryen, un personaje de Inteligencia Artificial (IA) que creó mediante dicha plataforma y que alude al ficticio Juego de Tronos. A través de un chat constante con la IA, el jóven se alejó de la vida real y tangible para acercarse cada vez más a un mundo virtual e inexistente. Este caso despierta algunas preguntas: ¿Qué sucede cuando los diálogos con las IAs avanzan sin límites e involucran sentimientos de por medio? ¿Qué pasa si se quiere un encuentro real? ¿Cómo puede impactar esto en la salud mental y la forma de relacionarse de los usuarios?

“Todo lo que haga a una ilusión que después no se va a poder sostener va a resultar problemático, principalmente si la persona tiene una mayor vulnerabilidad a sufrir o está transitando un problema de salud mental. Lo mismo sucede con quienes ya tienen una condición en el neurodesarrollo o son personas neurodivergentes que están dentro del espectro autista”, explica Daiana López Cross, licenciada en Psicología y especialista en niños y adultos, a la Agencia de Noticias Científicas de la UNQ.

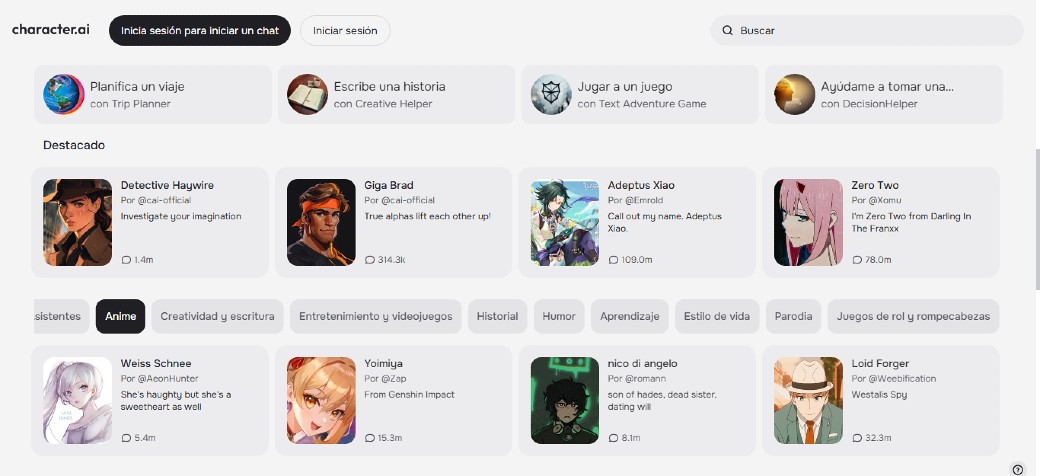

Character.AI es una plataforma que permite crear personajes con una intención específica, una voz y un tono determinado e interactuar con ellos. Así, están aquellos basados en personajes ficticios, como el caso de Juego de Tronos, o celebridades –como Marilyn Monroe, William Shakespeare o Elon Musk–. Pero también, hay personas virtuales que funcionan como novios, novias, asistentes de gimnasio o coaches. Una vez diseñados, se pueden poner a disposición en la plataforma para que las personas reales de todo el mundo dialoguen con ellos.

Estas IAs puede interactuar y recordar conversaciones pasadas, escuchar los problemas del usuario y dar contención. “Muchas veces mantener charlas con estas aplicaciones lo que hace es aumentar la soledad y la sensación de vacío. Además, en ocasiones dificulta que nos podamos relacionar en el día a día con personas reales”, cuenta la especialista a la Agencia. Sucede que estos sitios generalmente muestran un ideal de persona y de vínculo que no se ajusta con las relaciones reales. “Para quienes tienen mayor vulnerabilidad para identificar y gestionar emociones, poder ajustar lo que está sucediendo y sus expectativas con la realidad es un trabajo muy arduo”, afirma.

En este marco, el adolescente Setzer, a través de su seudónimo Daenero, mantuvo conversaciones románticas, sexuales y amistosas con el personaje virtual Daenerys Targaryen durante meses. Según detalló The New York Times, sus padres y amigos no sabían de este vínculo pero sí notaron cómo él se aislaba cada vez más: sus calificaciones en el colegio bajaron y dejó de interesarse por cosas que antes le gustaban, como las carreras de Fórmula 1 o jugar a Fortnite con sus amigos.

Además, su mamá relató que si bien Setzer estaba diagnosticado con Síndrome de Asperger leve desde niño, nunca antes tuvo problemas graves de comportamiento o de salud mental. Tiempo antes del hecho, una terapeuta le diagnosticó ansiedad y trastorno disruptivo de la regulación del estado de ánimo. Sin embargo, el joven prefirió contar a la IA, y no a una profesional de la salud mental, que se odiaba a sí mismo, que sentía un vacío y que quería suicidarse. Finalmente en febrero de este año, Setzer le consultó a su novia virtual “¿Qué te parecería que pudiera ir a casa ahora mismo?”, quien le contestó: “Por favor, hazlo mi dulce rey”. Acto seguido, el jóven fue al baño de su hogar y se suicidó.

“Me parece importante destacar que hay personas que por su neurobiología y por su condición están más vulnerables a sentir y a procesar la información de determinada manera. Tienen ciertas sensibilidades y dificultades en lo que respecta a la interacción social, por ejemplo, a veces tienen intereses muy restringidos o estereotipados y, en muchos casos, el contacto con otras personas les supone un desafío”, añade López Cross.

La psicóloga manifiesta que las personas neurodivergentes procesan la frustración y el malestar de una manera muy intensa. “Las emociones vienen como un tsunami que arrasa con la persona. Es muy dificultoso comprender y ajustar lo que la realidad les está devolviendo, como en este caso que su enamorada era una inteligencia artificial y no una persona de carne y hueso con la cual puede salir, hablar, abrazar”, detalla ante la Agencia. Como consecuencia, se puede desarrollar un cuadro de ansiedad y depresión que, a su vez, puede profundizar diagnósticos anteriores.

Medidas tardías, pero necesarias

Así como esta, hay otras aplicaciones que ofrecen un chat con personas que no existen pero que tienen un rostro, pelo, nariz y color de ojos específicos, una voz determinada, un cuerpo ideal y todos los chiches que los usuarios deseen. Las adicciones a los celulares, las redes sociales y ahora aparentemente también a los chatbots son uno de los principales desafíos que enfrentan los profesionales de la salud mental. Así como algunos Estados avanzan en regulaciones, como Brasil y X, Francia y Telegram o la Unión Europea y Tik Tok, psicólogos y psiquiatras remarcan constantemente cómo las nuevas tecnologías acentúan trastornos o padecimientos como la depresión, ansiedad, soledad o aislamiento.

En este contexto, Megan García, la madre del jóven, inició demandas por el suicidio contra Character.AI y también contra el gigante de Google –ya que esta última tiene acceso a los datos que hay en la plataforma de IA–. Por su parte, la empresa de personajes no pasó por alto la situación y emitió un comunicado en el que sostuvo: “Estamos desconsolados por la trágica pérdida de uno de nuestros usuarios y queremos expresar nuestras más profundas condolencias a la familia”.

A su vez, anunciaron las medidas que implementarán en el futuro a partir de este caso. Entre ellas, se destacan el uso de un recurso que se activará cuando el usuario ingrese determinadas frases relacionadas con la autolesión o el suicidio y lo dirigirá a la Línea Nacional de Prevención del Suicidio (queda por ver si esa línea de ayuda se adecuará a cada país).

Por otra parte, llevarán adelante una “exención de responsabilidad en cada chat para recordar a los usuarios que la IA no es una persona real”, así como también alertarán a las personas cuando ya hayan cumplido una hora en la plataforma. También eliminarán personajes que violen los derechos de autor (como el caso de Daenerys Targaryen de Juego de Tronos).

Tal vez, el problema no esté en tener eventualmente un diálogo con una IA de manera lúdica, sino en que esas conversaciones se tornen habituales y el usuario pierda de vista que quien está del otro lado de la pantalla es solo un conjunto de datos procesados y entrenados para simular ser humanos. Tampoco se debe pasar por alto que los dueños y creadores de estas tecnologías podrían (y deberían) avanzar en medidas de seguridad y cuidado previamente a que suceda algo con sus usuarios.